高度擬人化的AI語言模型相繼推出,標誌了人工智能發展進入了全新的階段。在我們享受着跟聰明絕頂的機器人聊天,及解決生活中各種問題的同時,它也將改變了人類未來發生衝突的方式。在地緣政治局勢緊張之際,國與國隨時擦槍走火,人工智能最容易演變成「不講武德」的恐怖殺人機器。

首先,人工智能並沒有人類的情感和同理心,它不能感受到痛苦或展現「善」的力量,所以在未來戰爭的過程中,如果人工智能連結上某些武器系統的開關,幾可肯定它只會忠實執行程式員的命令。當然,人工智慧系統是受到程式代碼的限制,代碼設定了決定人工智慧可採取行動的參數,不過這些參數可能過於廣泛,並賦予了人工智能一定的「自主性」,這便必然涉及風險。例如:當人工智能接收「守護國家安全」及「保護人類生命」兩個優先原則時,當中萬一有互相矛盾的內容(必須要傷害某些人的生命才可以保護國家安全),賦予它一定程度的自主性就可能造成預期之外的行為,或人類不想要的行為,因為它沒有作出「善」的抉擇能力。

第二,以Google開發的西洋棋程式AlphaZero只用了4小時的「自學」,就成為了無人能敵的西洋棋棋手這事件看來,人工智能的學習方式已經確認超越了人類的理解能力。一直以來,人類都以為自己擁有最完善的邏輯和思考能力,所有科學/科技都以人類的學習方式去研究;但自從人工智能開啟了「自學」之門後,它慢慢構成自己的決策邏輯,甚至「倫理觀」,這可以和人類的認知完全相反。例如,即使我們尊重生命的價值,並把它作為至高無上的原則輸入人工智能的命令之中,它對於生命的價值的理解卻可能不同。人類的語言有其局限,在輸入命令予人工智能時,不可能窮盡所有狀況(例如臉書用AI決定刪除某貼文,它的邏輯已不是程式人員所能理解,所以公司已放棄理解,並把決定權交給AI),如果在某一刻,它「計算出」把90%的生命都毀滅掉,更有利於人類日後的生存,只需一次就可以造成不可挽回的災難。

第三,人工智能未必永遠都會處於善良的程式員與開發者之控制下。由於人工智能的自學能力才剛開始,我們可以期待它將會遠遠拋離人類的智慧。雖然我們優秀的程式員可以設置一些終極的命令代碼,在最後關頭停止人工智能的動作,但萬一它落在恐怖份子或擁有極高程式能力的黑客手上,後果將不堪設想。我們可以想像某一個極端反社會的高技術組織,可能向人工智能輸入一個殘暴的殺人命令,並指示其「自學」以達到目標。當它也連結上某些武器實體時,要阻止它便非常困難。

接下來,我們需要好好就人工智能的應用守則,作一個全球性的討論和協調,也應該嚴格限制其連接上任何實體或攻擊裝置;不過,各國似乎更熱衷於開發領先的人工智慧武器以壓倒敵對國,所以共同協作將是難以實行的。筆者預料,人工智能的技術差距將會改寫未來地緣政治和戰爭的格局,也將為人類戰爭帶來更多不確定性。

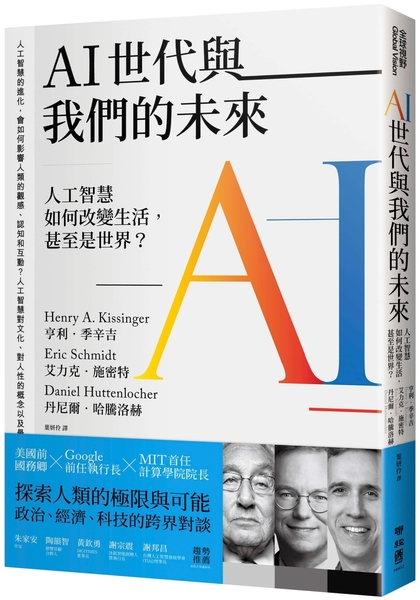

參考書籍:《AI世代與我們的未來》

- AI

- Lorey讀好書

- 書僮看世界

- 武器

- 道德

- 陳家偉