騙徒的手法不只層出不窮更會與時並進,最近出現以人工智能(AI)等技術犯案。警方表示,近期接獲兩宗騙徒利用AI及「深偽技術」(Deepfake)詐騙的呈報,其中有受害人與騙徒進行視像通話後,樣貌被移花接木到色情影片,被勒索1萬元。警方又表示,近期有不少市民收到來歷不明的Facetime視像電話,有可能是騙徒想趁機盜取生物資料,呼籲市民不要接聽不明來電。

透過社交平台公開影像套取聲音和臉部訊息

警方表示,留意到近幾個月,有騙徒懷疑借助AI深偽技術製作虛假新聞報道,推介投資活動,或冒充名人移花接木後製影片,引誘市民參與不存在的投資計劃。此外,也有騙徒利用相關技術實時換臉換聲,透過視像通話假冒受害人親友要求匯款。

警方指,不法分子透過社交平台的公開影像,套取冒充對象的聲音和臉部訊息,再透過深偽技術製作影片,在視像通話中播放,騙徒之後會利用各種藉口完結通話,再要求受害人轉換到其他即時通訊軟件繼續對話,從而繼續詐騙行為。

警方表示,一名身在外地的日籍人士在社交平台認識了一名冒認香港銀行高層的騙徒,誤信以深偽技術製造的假新聞片,被騙參加投資計劃,因此向騙徒轉帳價值1700港元的點數卡。另外,有受害人經交友平台認識騙徒,根據指示下載手機軟件,進行短暫視像通話後,發現樣貌被移花接木到色情片段,繼而被騙徒勒索1萬元,該名市民因感到懷疑而報警求助,最終未有受騙。

深偽技術非完美 做大動作會穿崩

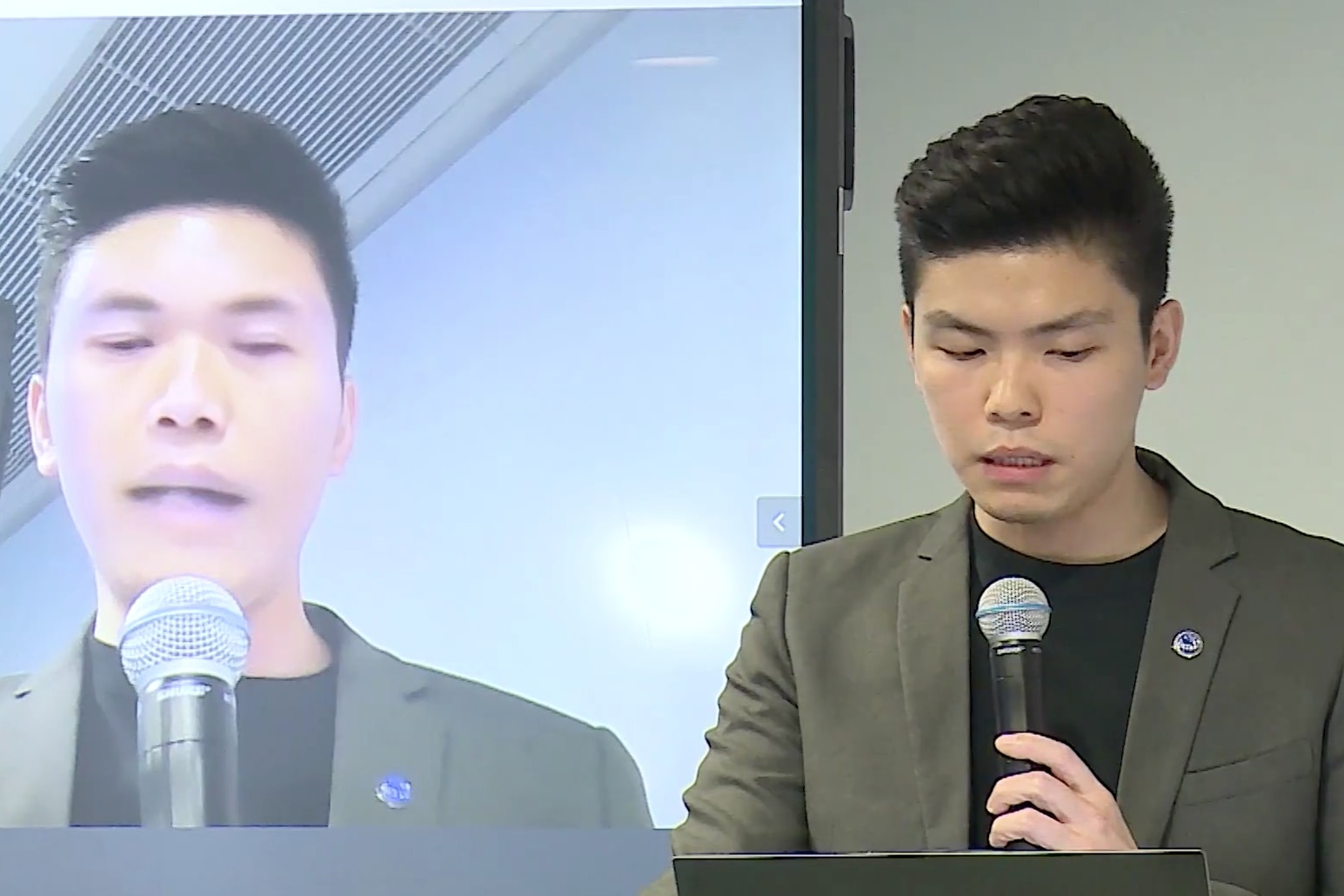

警方網絡安全組高級督察陳智穎指出,騙徒的深偽技術並非完美,市民可留意影片中的人物眼神和口型是否有不自然的地方,遇到可疑的視像通話是,可要求對方在鏡頭面前舉起手指並橫向移動,或將頭部上下左右轉動。由於突如其來改變需重新運算,影片質素會受影響露出破綻,市民便可識破詐騙。

警方又表示,近期有不少市民收到來歷不明的Facetime視像電話,有可能是騙徒想趁機盜取生物資料,呼籲市民不要接聽不明來電。

記者:Kit

閱讀更多: